前言:

过去这一个月

大家都被DeepSeek刷屏了!

从12月DeepSeek横空出世,宣布开源到现在相信大家都已经通过各种渠道感受到他的火爆!

面对源源不断的DeepSeek服务器繁忙,稍后再试与API涨价300%的新闻

也是特别整理了一个快捷的本地免费部署DeepSeek喂饭级教程~相比市面上已有教程

本攻略全程仅有一句代码

只需五个步骤

即使是毫无代码经验的朋友

也可以在飞牛NAS使用本地模型!

主打一个小白也能玩!

通过内网IP进入飞牛web页面选择docker-镜像仓库-搜索ollama-点击下载(若下载失败,可以尝试更换docker仓库:https://docker.1ms.run/)

第二步,配置与运行Ollama 镜像

进入容器-Ollama-右侧三个点-容器设置端口设置-输入外部访问的端口11435 容器内部端口11434(默认)

储存位置-点击文件夹图标-添加新建的ollama文件夹路径填写 /root/.ollama

进入环境变量-添加变量 OLLAMA_ORIGINS = *

根据你的飞牛NAS配置,选择合适的模型版本对应的运行代码

输入ollama run deepseek-r1:[版本号] 回车

最后出现success,表示下载运行 deepseek-r1 成功!

进入飞牛应用中心-实用效率-找到LobeChat点击安装

在服务地址输入 http://[你的局域网ip地址]:11435获取并选择模型,deepseek-ri点击检查,展示 检查通过 即为连接成功

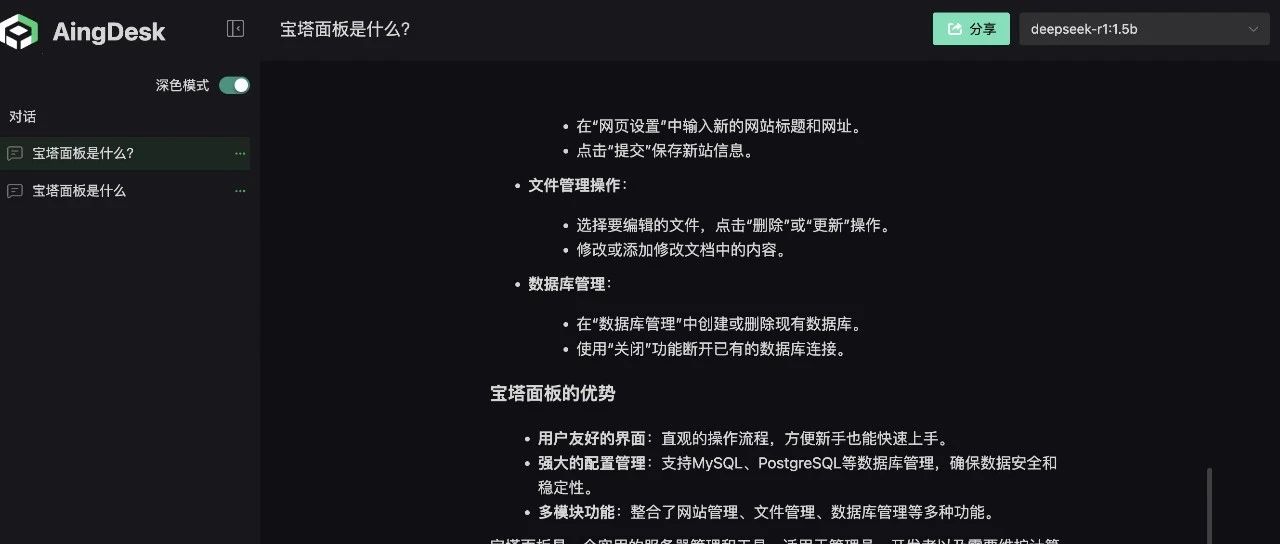

返回LobeChat对话页面,选择已经配置好的模型,就可以开始对话啦!

接下来,直接跟你的本地飞牛NAS上的DeepSeek对话啦!当然这里的对话速度跟NAS的配置有一定关系不过亲测,十年前的笔记本组的NAS也可以流畅运行1.5b模型~

第二步,配置与运行Ollama 镜像

进入容器-Ollama-右侧三个点-容器设置端口设置-输入外部访问的端口11435 容器内部端口11434(默认)

储存位置-点击文件夹图标-添加新建的ollama文件夹路径填写 /root/.ollama

进入环境变量-添加变量 OLLAMA_ORIGINS = *

根据你的飞牛NAS配置,选择合适的模型版本对应的运行代码

输入ollama run deepseek-r1:[版本号] 回车

最后出现success,表示下载运行 deepseek-r1 成功!

进入飞牛应用中心-实用效率-找到LobeChat点击安装

在服务地址输入 http://[你的局域网ip地址]:11435获取并选择模型,deepseek-ri点击检查,展示 检查通过 即为连接成功

返回LobeChat对话页面,选择已经配置好的模型,就可以开始对话啦!

接下来,直接跟你的本地飞牛NAS上的DeepSeek对话啦!当然这里的对话速度跟NAS的配置有一定关系不过亲测,十年前的笔记本组的NAS也可以流畅运行1.5b模型~

提示:本文最后更新于2025年2月12日,如有错误或者已经失效,请留言告知。

------本页内容已结束,喜欢请分享------

感谢您的来访,获取更多精彩文章请收藏本站。

------关注微信公众号:映凡空间------

------关注微信公众号:映凡空间------

Invitation

created:2022/05/10

Nice to meet you!

Use this card to join the YingFan's Space and participate in a pleasant discussion together .

Welcome to YingFan's Space,wish you a nice day .

第二步,配置与运行Ollama 镜像

第二步,配置与运行Ollama 镜像